Что такое отравление данных, и зачем оно нужно

В конце октября 2023 года окружной судья США отклонил иск трех художников к Stability AI, Midjourney и DeviantArt. Претензии digital-творцов заключались в нарушении авторских прав: работы, которые они создавали и публиковали, стали учебным материалом для генеративного ИИ. Разрешения художников никто не спрашивал. Посягательство на интеллектуальную собственность, наверное, вторая по частоте претензия к ИИ после вытеснения человека с рабочих мест. Но в этом случае человеку есть, чем ответить.

Что это такое

Чтобы защитить авторов, команда Чикагского университета разработала инструмент Nightshade, в переводе — «паслен». Это усовершенствованная версия Glaze, алгоритма, который помогал маскировать уникальный художественный стиль изображений. Nightshade — программа, которая изучает уязвимости генеративных ИИ, например, параметры изображения, на которые ИИ сильнее всего ориентируются, и незначительно меняет эти параметры. В результате модель получает искаженное представление о предмете и генерирует абсурдные изображения, которые не отвечают запросу пользователя. «Nightshade — последний рубеж защиты от веб-скрейперов, которые игнорируют директивы о несканировании», — говорит Бен Чжао, лидер команды.

Источник: This new data poisoning tool lets artists fight back against generative AI | MIT Technology Review

«Теплица» обратилась за комментарием к чат-боту Rebels.ai, компании, интегрирующей ИИ в бизнес, и ее создателю Максиму Мусину. По их словам, чтобы нарушить работу модели, достаточно буквально 1-2% «отравленных» изображений, если показать их ей на раннем этапе, когда она еще обучается.

Как работает алгоритм

Когда создатель выкладывает свое творчество на Pinterest, Shutterstock или на свой личный сайт, веб-скрейперы могут скачать его и добавить в набор данных. Но если перед публикацией изображения заменить в нем несколько пикселей, то модель, которая будет использовать его как учебный материал, обучится неправильно. Модели видят изображения как числовые массивы и используют математические формулы для генерации картинок. Nightshade немного меняет эти числовые представления. Инструмент не вмешивается в алгоритмы ИИ, а только в данные, которые он получает.

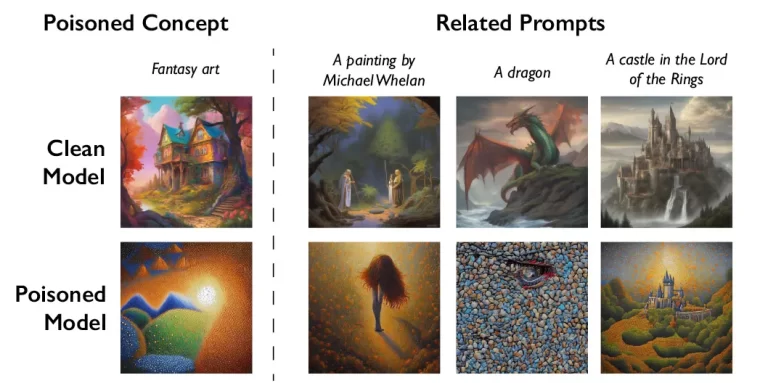

Помимо этого, инструмент использует сильные стороны генеративного ИИ, чтобы распространить заразу. ИИ умеет находить взаимосвязи между родственными понятиями, и Nightshade заражает не только на конкретное слово-запрос, но и связанные с ним слова. Например, если в датасет затесалась «отравленная» картинка с пометкой «фэнтези», то модель сгенерирует некорректные изображения в том числе для промптов «дракон» и «Властелин колец». Вот что создает модель, обученная на «отравленных» картинках:

Источник: This new data poisoning tool lets artists fight back against generative AI | MIT Technology Review

Отыскать и удалить «отравленные» элементы из датасета чрезвычайно сложно, и если их будет много, ИИ начнет рисовать кошек вместо собак, коров вместо машин и тостеры вместо сумочек.

Критика и риски

Одно из самых распространенных замечаний — маломасштабность Nightshade. Так, многие модели преобразования текста в изображение обучались на базе данных некоммерческой организации LAION, которая содержит 5,85 млрд картинок и соответствующих им текстовых описаний. Для нарушения результатов генерации понадобится соответствующая доля зараженных изображений. На это разработчики возражают, что Midjourney, Stable Diffusion, DALL-E и другие должны будут обновляться, так что данные для будущих версий этих ИИ можно «отравить». Последнее тестирование показало, что даже 100 обработанных «пасленом» изображений смогут испортить эффективность ИИ. По словам Бена Чжао, «AI-тренеры могут откатить модель до предыдущей версии, но конструировать новые им будет непросто».

В то же время, обновление систем считается главным обстоятельством, фактически обесценивающим пользу от заражения данных. Зараженные элементы или будут удалены, или алгоритмы научатся автоматически их выявлять и блокировать.

Еще одна проблема — обработанные изображения начнут неправильно или плохо индексироваться поисковиками. Если Google и другие системы не смогут категоризировать визуальный контент, это в конечном счете ухудшит просматриваемость профилей самих художников.

Кроме этого, существуют риски злонамеренного использования Nightshade. Среди них:

— программирование «отравления» так, что ИИ, которому они попадутся, станет генерировать не кошек вместо собак, а нецензурные изображения. Это осуществимо, если хакер изучит предвзятость модели (model bias) и подаст на вход определенно обработанные данные;

— взлом аккаунтов независимых медиа или активистов и размещение в них «отравленных» картинок, которые алгоритмы соцсетей будут воспринимать как нарушающие правила, и блокировать аккаунт;

— утечки учебных данных и последующее за этим вторичное нарушение авторских прав;

— в случае масштабного проникновения «отравленных» изображений и нарушения работы генеративных ИИ — снижение доверия к ИИ в целом, затруднения в работе специалистов, которые на него полагаются.

Послесловие

«Паслен» — не уникальный в своем роде инструмент, создающий помехи при попытке использовать контент без разрешения. В конце ноября 2023 года команда Вашингтонского университета представила AntiFake — программу, которая предотвращает синтез речи. Синтез речи используется мошенниками для создания голосовых дипфейков и обмана жертвы. До публикации к звуковой записи применяется AntiFake, который меняет сигнал так, что ИИ не может считать характеристики, нужные для сотворения фейка. При этом, обработанная запись для слушателей звучит так же, как и необработанная.

Эксплуатация творчества искусственным интеллектом пока вызывает беспокойство у относительно небольшого числа авторов. По крайней мере, судебные иски можно пересчитать по пальцам. Впрочем, обвинения в неэтичности вредят репутации инвесторов, поэтому можно ожидать ужесточения законодательства относительно ИИ-скрнейпинга. Сам Чжао предполагает, что Nightshade запустит игру в кошки-мышки с разработчиками искусственного интеллекта. А мы признаем, что изображение для этого материала создал Midjourney.

Источники

- This new data poisoning tool lets artists fight back against generative AI | MIT Technology Review

- [2310.13828] Prompt-Specific Poisoning Attacks on Text-to-Image Generative Models

- Photo giant Getty took a leading AI image-maker to court. Now it’s also embracing the technology | AP News

- Countering The Underrated Threat Of Data Poisoning Facing Your Organization

- This artist is dominating AI-generated art. And he’s not happy about it. | MIT Technology Review

- [2106.14851] Data Poisoning Won’t Save You From Facial Recognition

- Nightshade’s «poison pill» could sabotage AI trained with unlicensed images

- AntiFake: Using Adversarial Audio to Prevent Unauthorized Speech Synthesis

- Defending your voice against deepfakes — The Source — Washington University in St. Louis

- How generative AI’s uncomfortable relationship with copyright law will determine the future of the industry | by Munjal Shah | Nov, 2023 | Medium