«Елена Зеленская, жена президента Украины Владимира Зеленского, якобы купила уникальный спорткар Bugatti Tourbillon за 4,5 млн евро (4,8 млн долларов) — на деньги, полученные Украиной по программе американской военной помощи». Видеоисточник этой новости, сгенерированный нейросетью, быстро разоблачили как фейк, но 12 млн пользователей X успели его увидеть. Как и аудитория прокремлевских СМИ.

С марта по май 2024 года OpenAI пресекла работу пяти «тайных операций по оказанию влияния», две из которых связала с Россией. Из всех вариантов неэтичного использования ИИ самый популярный — дипфейки на политические темы. Зачем это делается и насколько эффективно — читайте ниже.

Ключевые выводы:

1. Инструменты ИИ обычно применяются для повышения эффективности существующих методов информационного воздействия, а не изобретения новых.

2. Основная аудитория операций по оказанию влияния — европейские и американские граждане, а проводят их аффилированные с государством структуры.

3. ИИ используется для генерации и перевода текстов, изображений и видео, отладки кода и комментирования. Комментарии проще распознать, чем видеодипфейки.

4. Подобные проекты не сильно увеличивают аудиторные охваты и почти не повышают просматриваемость, но измерить, как они влияют на пользовательское восприятие политической повестки, сложнее.

5. Для русскоязычной и не русскоязычной аудиторий генерировались разные сообщения, адресованные разным пользовательским болям.

6. Цель этих кампаний — манипулирование общественным мнением и внесение разногласий в дискуссии.

Цели

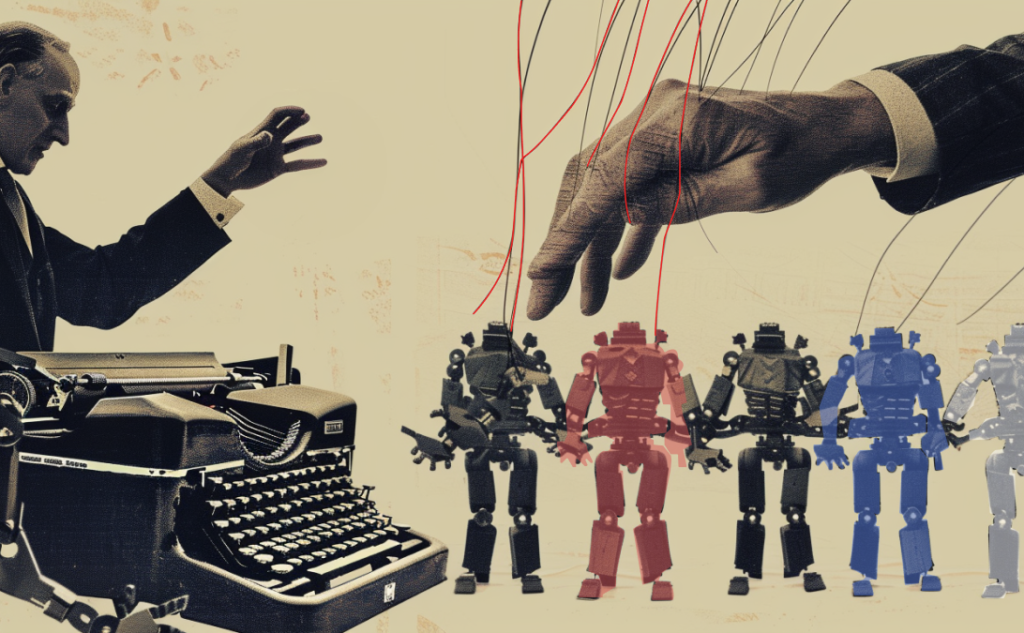

Под интригующим «тайные операции по оказанию влияния» скрываются действия, знакомые всем, кто хоть раз слышал о ботофермах. Цель этих операций — манипулирование общественным мнением и влияние на политическую повестку. Манипулирование не должно быть явным: комментарии в поддержку России вряд ли вызовут положительный отклик иностранной аудитории, но призыв сосредоточиться на внутренних проблемах имеет на это шансы. Каждая операция представляет собой кампанию по достижению внешнеполитической цели: ослабление поддержки Украины, влияние на исход выборов в США и тд. Некоторые операции меняют мишень в зависимости от обстановки, к примеру, накануне выборов в Европейский парламент.

Улучшение имиджа России — далеко не самая главная цель таких мероприятий. Как правило, их фокус — на снижении доверия государственным и международным институтам, внесении раскола в общественное мнение и подчеркивании необходимости заняться своими внутренними проблемами, а не поддерживать Украину. Чтобы выглядеть естественно, участникам кампаний нужно понимать настроения внутри страны, грамотно писать и мимикрировать под среднестатистического пользователя.

О том, успешны ли такие кампании, можно судить не только по количественным показателям вроде числа шеров и лайков. Обычно публикации и комментарии про бесполезность войны в Украине и коррупцию правительств получают мало взаимодействий, так как выглядят неоригинально и довольно топорно. Но когда их много, создается информационный пузырь, в который попадают пользователи. У них возникает ощущение, что они одиноки в своих убеждениях и не в силах ничего изменить. Сомнения, путаница, недоверие друг другу и СМИ — неблагоприятная почва для гражданского общества. Это приводит к политической апатии и позиции «не все так однозначно».

Методы

Европейские службы по защите от иностранного вмешательства назвали организаторами операций «Агентство социального проектирования» и «ГК СТРУКТУРУ», которые сотрудничают с российскими властями и находятся под санкциями. Они применяли ИИ не для создания принципиально новых тактик, а скорее для оптимизации старых. Среди самых популярных направлений — генерация комментариев и статей на разных языках и клонирование сайтов.

Вторая схема получила название «Доппельгангер» (с нем. Doppelgänger — «двойник», темная сторона личности). Она означает копирование сайта известного СМИ, таких как Le Monde, Der Spiegel и тп, и наполнение его прокремлевским контентом. Пользователи думают, что зашли на привычный веб-ресурс, и читают материалы, продвигающие российскую повестку. Авторство таких материалов может приписываться реально существующим журналистам. Иногда вместо дублирования создается новое «СМИ» с названием, имитирующим известные медиа, например, Jerusalem Herald Tribune или Patriotic Review. О связи поддельных медиа-сайтов с Россией порой можно догадаться по названию: notrepays today, franceeteu today (по аналогии с Russia Today). В ходе одной из кампаний по оказанию влияния 120 фейковых сайтов были созданы всего за три дня, с 10 по 12 мая 2024 года.

Для создания, перевода и корректуры статей для сайтов-самозванцев применялся ИИ. В некоторых случаях искусственный интеллект ходил по настоящим новостным сайтам, выкачивал оттуда материалы и переписывал их в правом политическом ключе. Также с помощью LLM наполнялись страницы «СМИ» на Facebook. Комментарии к этим постам зачастую тоже генерировались ИИ, чтобы имитировать вовлеченность аудитории.

Короткие комментарии, сгенерированные искусственным интеллектом, распространялись в Telegram, X (Twitter), Instagram. Обычно они критиковали действия Украины и ее поддержку странами Запада, но воздействовали на разные болевые точки. Русскоязычные «комментаторы» обвиняли президента Украины в коррупции и предательстве интересов своих граждан в угоду Западу. Англоязычные указывали на проблемы с иммиграцией, экономические трудности, в частности, из-за антироссийских санкций, и требовали сосредоточиться на внутренней, а не внешней политике. Целевую аудиторию, на которую были рассчитаны эти комментарии, составляли жители России, Украины, США, Молдовы и стран Балтии. OpenAI назвала операцию по комментированию «Плохая грамматика».

Кроме этого, LLM использовались для отладки кода для автоматического постинга в Telegram и для генерации видео. Крупные text-to-video модели блокируют промпты про политиков, но ролики необязательно целиком должны быть сгенерированы нейросетью. Достаточно воссоздать голос, благо образцов голоса известных личностей в открытом доступе достаточно, и воспользоваться технологией замены лиц (face swap).

Видео-дипфейк про Байдена в инвалидном кресле, который раздает деньги нелегальным мигрантам и украинцам вместо американцев, набрало 5 млн просмотров и 6,5 млн шеров в X всего за месяц. Фильтры соцсетей, которые должны выявлять сгенерированные видео, не сработали: операторы обрезали несколько видеокадров на миллисекунды так, чтобы человеческий глаз ничего не заметил. Из-за этих манипуляций системы защиты от злоупотреблений распознали видео как уникальное. Экспертам не удалось установить, какую нейросеть использовали злоумышленники.

Как распознать

Корпорации заявляют, что борются с использованием своих продуктов в политических целях. В случае с моделями text-to-image они более-менее контролируют ситуацию: запретить генерировать изображения публичных лиц и политиков технически намного проще, чем банить создание комментариев для спора в интернете. Meta сотрудничает с независимыми командами фактчекеров, помечающих ИИ-сгенерированный контент и дезинформацию, Amazon использует искусственный интеллект для анализа подлинности отзывов. Российский проект bot blocker | блокировщик ботов активно занимается разоблачением фабрик троллей и помогает журналистам-расследователям выявлять дезинформацию в X (Twitter). Еще один российский проект, бот «Насквозь», анализирует тексты статей и показывает наличие и типы эмоциональных манипуляций.

Для обнаружения операций по прикрытию OpenAI разработала и запустила отдельные модели. Они анализировали большой объем данных и находили паттерны использования ИИ злоумышленниками. Но самые заметные ошибки были и допущены, и обнаружены людьми. Они забывали удалять системные сообщения об отказе из публикуемых постов, оставляли антиукраинские комментарии к видео про Газу.

Но можно не надеяться на техногигантов и разобраться самостоятельно. Инструменты, которые идентифицируют дипфейки, часто основаны на тех же принципах машинного обучения, что и нейросети, которые их создают. А именно, GANs*, классификации, предсказания (вероятность появления определенного слова вслед за каким-либо словом в предложении) и тд. Hive и AI Voice Detector анализируют видео и аудио на предмет ИИ-манипуляций. Scribbr, zeroGPT и QuillBot оценивают вероятность того, что текст был сгенерирован нейросетью, и помогают перефразировать его. Причем Scribbr и zeroGPT даже распознают русский язык. Illuminarty, Is It AI выполняют аналогичную задачу с картинками, правда, уровень точности у них ниже, чем у текстовых «ИИ-следователей». А вот здесь можно пройти тест и узнать, насколько хорошо вы сами способны отличить настоящие фото от фейковых.

Кроме этого, полезны такие простые инструменты, как обратный поиск и метаданные. Если вы сомневаетесь в подлинности изображения, поищите его в Google Images, TinEye или Yandex. Выдача результатов по сгенерированным картинкам будет тоже состоять из сгенерированных картинок или изображений, не похожих на исходное. Метаданные, или данные EXIF, («Свойства» загруженного изображения) показывают, на какую камеру был сделан снимок, время экспозиции и тд. В случае со сгенерированным изображением, этой информации не будет. Правда, способ не стопроцентный: некоторые соцсети удаляют метаданные фотографий при загрузке на их сервера, и таким же образом иногда поступают фотографы и художники перед загрузкой своего творчества в интернет.

Насколько успешными будут операции по оказанию влияния, зависит не только от цифровой грамотности пользователей, но и от провайдеров генеративного ИИ, которые позволяют создавать дипфейки. А еще от политики соцсетей, в которых это творчество находит свою аудиторию. Если создатели инструментов будут вставлять машиночитаемые водяные знаки во все генерируемые материалы, а соцсети выявлять и блокировать аккаунты, которые постят такой контент, операций по оказанию влияния можно не опасаться.

*GAN (Generative adversarial network, генеративно-состязательная сеть), представляет собой принципы и алгоритмы машинного обучения, которые основаны на антагонизме двух нейронных сетей. Модель генерирует что-либо и одновременно критикует саму себя, отсеивая неправдоподобные, непохожие результаты.

Источники

Political deepfakes top list of malicious AI use, DeepMind finds

A Russian Propaganda Network Is Promoting an AI-Manipulated Biden Video | WIRED

Russia-Linked CopyCop Expands to Cover US Elections, Target Political Leaders | Recorded Future

A GAN-Based Model of Deepfake Detection in Social Media — ScienceDirect

How to Detect AI-generated Content

Meet Antibot4Navalny: the mysterious researchers exposing Russia’s war on truth — The World from PRX

Threat Intel Report — AI and Covert Influence Operations

Ex posed: How Russia tries to exert influence on public opinion in Israel