Как определить сексистский или, наоборот, феминистский контент в Интернете? Часто мы больше всего внимания обращаем на язык и вообще смысл, сформулированные на словах. Но сексизм и другие формы дискриминации существуют не только в языке. В первом спецвыпуске International Journal of Communication за 2021 год собрано девять академических статей о том, проникают ли гендерные стереотипы в аудиовизуальные формы – гифки, рекламу, сериалы – и даже в программный код алгоритмов. Ольга Тараканова рассказывает о самых интересных выводах и инструментах анализа.

Предубеждения алгоритмов

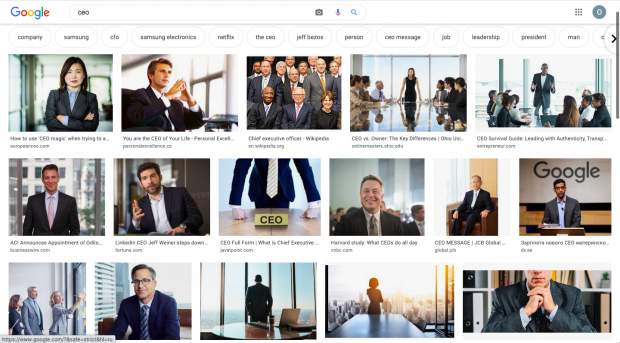

Если загрузить в определитель лиц картинку белого мужчины, программа верно распознает пол человека в 99% случаев, а если черной женщины – то лишь в 35%. Если выгрузить из программы для автоматического текстового описания изображений базу ассоциаций, то мы узнаем, что раз на фото кухня, то на нем, вероятно, и женщина. Если вбить в поиск по картинкам CEO (chief executive officer, исполнительный директор, но в английском языке это слово гендерно-нейтральное, а не мужского рода), то почти на всех фотографиях будут мужчины.

Алгоритмы воспроизводят стереотипы, которым сейчас подчинено человеческое мышление. Но почему и как именно это происходит? Исследовательница Мирен Гутьеррес в своей статье выделяет пять типов предубеждений о гендерном порядке, которые определяют работу алгоритмов (Гутьеррес опирается на статью, в которой представлено еще больше – целых 23 – типа алгоритмических предубеждений).

- Ошибка презентации – когда фотографии женщин попадают на первые полосы газет, они, как правило, либо знаменитости, либо жертвы насилия или катастрофы, либо сняты топлес – то же и с Интернетом, ведь только на такие картинки кликнут многие пользователи.

- Ошибка предпочтений – когда пользователи активно реагируют на сексистский контент, алгоритмы подгружают похожий и фильтруют нейтральный или феминистский.

- Ошибка выборки – когда для обучения алгоритмов используется случайная выборка, то на самом деле в нее попадает в основном контент, произведенный белыми англоговорящими мужчинами, – ведь они все еще составляют большинство в цифровой среде.

- Ошибка опоры на историю – когда алгоритмы делают прогноз на основании прошлого опыта человечества, они по сути опираются на историю, в которой женщины были угнетены.

- Ошибка агрегации – когда алгоритмы принимают решение на основе данных обо всех пользователях, информация о которых доступна, они не учитывают возможные отклонения от средних показателей в любой специфической категории, например, среди женщин.

В целом, алгоритмы иногда не просто воспроизводят, но и усиливают существующие среди людей предубеждения. И, таким образом, подогревают предубеждения в людях.

Аудиовизуальные стереотипы

Распознавание лиц, иллюстрация к статьям в медиа, базы текстовых ассоциаций или описаний к картинкам – какие еще сферы цифрового мира подвержены сексизму?

Сексизм бывает не только визуальным, но и звуковым. Например, почти все голосовые помощники разговаривают женскими голосами, таким образом подкрепляя ассоциации женщин с трудом заботы и домашним трудом. Другой случай – голоса автоответчиков или даже распределение живых сотрудниках в колл-центрах. Известно, что в Японии брокерские фирмы сообщают котировки акций женскими голосами, а вот подтверждают транзакции – мужскими. Наконец, распознаватели речи вроде автоматического инструмента для создания субтитров в YouTube лучше распознают мужские голоса, чем женские.

Кроме того, возможна и некорректная обработка аудиовизуального контента из-за пренебрежения или манипуляций с текстовыми данными. Так, разработчик Facebook’а Рене Байвенс показал, что соцсеть хоть и позволяет пользователям выбрать свой гендер из множества, а не из двух, но затем отслеживает, каким местоимением человек пользуется в постах, и в работе рекламных алгоритмов возвращает пользователя в бинарную систему: либо «он», либо «она» (хотя есть ведь и местоимение «они»!).

Отдельная статья в выпуске посвящена гендерным стереотипам в базах данных GIF’ок, которые встраиваются в Telegram, Facebook и другие мессенджеры. Хотя исследователи (Диего Альварес, Алехандро Гонсалес, Кристина Убани) не выявили прямой зависимости содержания гифок от гендера людей, которые изображены на них, интересно, по каким параметрам они предлагали анализировать картинки (вслед за исследовательницей Сюсаной де Андрес дель Кампо):

- вербальное кодирование – использование стереотипных подписей к картинкам или названий;

- кодирование письмом – использование разных шрифтов для создания маскулинизированного или феминизированного образа;

- хроматическое кодирование – использование разных цветов в связи с гендером;

- фотографическое кодирование – под этим подразумевается обработка фотографий, например, ретуширование тела;

- морфологическое кодирование – акцент на отдельных частях тела для передачи смысла;

- социокультурное кодирование – использование особых поз, жестов, как, например, приоткрытый рот, прикосновения к губам или прическе у женщин, активная агрессия, крик у мужчин.

Опираясь также на другие исследования гендерных стереотипов в изображениях, в итоге Альварес, Гонсалес и Убани, точнее, приглашенные ими тестировщики, описали сотни гифок по следующим параметрам: стиль шрифта, этничность, возраст, вес, цвет волос, длина волос, откровенность одежды, нагота, размер груди, уместность одежды, объективация, тип жеста, основная эмоция, улыбка, приоткрытый рот, надутые губы, прикосновение к лицу, прикосновение к волосам, большие глаза, жесты рук. Что интересно, в итоговой базе данных пришлось отказаться от описания веса, цвета волос, длины волос, размера груди, типа жеста и основной эмоции – слишком существенные отличия возникли в описаниях разных тестировщиков.

Как улучшить ситуацию

Мирен Гутьеррес выделяет три причины, по которым сексизм все еще заметен в аудиовизуальных цифровых индустриях и на которые можно повлиять вручную.

- Во-первых, цифровой сектор пока далек от гендерного баланса. И речь не только о начальницах или разработчицах, но также, например, о тестировщицах приложений и сайтов – в основном тестируют продукты мужчины.

- Во-вторых, только в исключительных случаях разработчики цифровых продуктов специально ориентируются на женщин-пользовательниц и каким-либо образом учитывают женский опыт и запросы в приложениях, если только они созданы специально для женщин.

- Наконец, отсутствует сильная юридическая база, которая противодействовала бы дискриминации. Ссылаясь на предложение AI Now Institute, исследовательница утверждает, что в новых законах нуждаются пять секторов, опирающихся сейчас на алгоритмические процессы: медицинская помощь, оценка качества преподавательской работы, социально- и естественнонаучная экспертиза, оценка уголовных рисков, биокриминалистика.

Более сложная проблема — отсутствие прозрачности в работе алгоритмов. Речь не только о том, что часто корпорации и небольшие фирмы не раскрывают, как устроен их код, но и о том, что подчас даже разработчики, написавшие код, не могут пошагово объяснить, как он работает. Таким образом, иногда пользователи сталкиваются со сбоящими «черными ящиками», отремонтировать которые человеческий разум не способен, – остается либо доверять им, либо остановить их работу.

Что еще есть в выпуске

Я сфокусировалась на выводах и инструментах анализа, которые касаются именно технологий. Многие другие статьи в выпуске посвящены сериалам и фильмам – например, исследователи разбирают, как в «Игре престолов» и «Очень странных делах» феминистский посыл сочетается на аудиовизуальном уровне со стереотипами, проводят контент-анализ произведений с женщинами в главных ролях, представленных на популярной испанской стриминговой платформе, выделяют характерные черты героинь-лидерок в анимационном кино.

Еще одна тема – стереотипы и борьба с ними в рекламе, в особенности – понятия фемвертайзинга, то есть рекламы, призванной поддержать и вдохновить женщин, и, по аналогии, менвертайзинга, то есть рекламы, которая расшатывает стереотипы о маскулинности и создает новые образы заботливых или чувствительных мужчин. Как устроены новые маскулинности, исследователи анализируют и применительно к кино – а именно, к таким исторически гипермаскулинным жанрам, как вестерн и полицейская драма.