В 2018 году о них начали говорить. В 2019-м – бояться. В 2020-м мы поняли, что это наша новая реальность.

Что такое дипфейк? Изначально – просто бесшовная замена одного лица на видео на другое так, что подделку нельзя отличить. Microsoft определяет это понятие более широко: deepfakes – это синтезированные медиа, которые представляют собой фотографии, видео- или аудио-файлы, манипулируемые искусственным интеллектом (artificial intelligence, AI) так, что подделку трудно обнаружить. Такие видео – разновидность создаваемых искусственным интеллектом видео (AI-generated video), многие из которых не относятся к подделкам и служат совсем другим целям.

В статье я расскажу о дипфейках в политике, порнографии, социальной сфере и… ритейле!

Зрение всегда было более надежным способом получения информации о реальности, чем текст. Лучше один раз увидеть, в конце-концов. Стопроцентная грамотность населения (и то только в Северном полушарии) достигнута исключительно в последние сто лет. Поэтому если что-то показали на видео – то, вероятно, так и было. Например, штурм Зимнего дворца:

(На всякий случай уточню, что штурма Зимнего дворца в октябре 1917 года не было, кадры – из художественного фильма.)

Поэтому дипфейк стал настоящей шок-технологией, от которой пока что нет абсолютной защиты – только критическое мышление и фактчекинг.

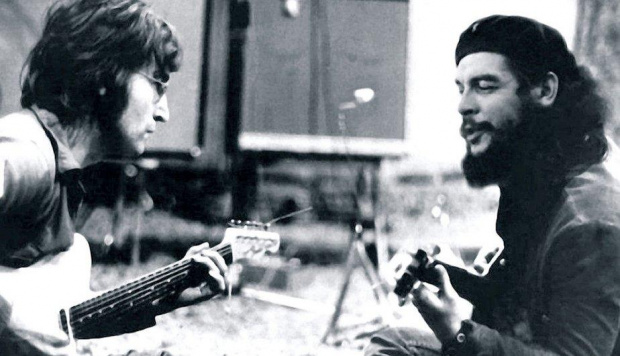

Вообще, идея манипуляций с изображением не нова и начала эксплуатироваться еще на заре фотографии:

Выглядит очень достоверно, но Че Гевара никогда не встречался с Джоном Ленноном, в оригинальном фото справа сидит Уэйн Габриэль.

Спецэффекты и компьютерная графика существуют уже не первый год, почему мы заволновались именно сейчас?

Раньше подделки такого уровня требовали оборудования, профессиональных исполнителей, бюджетов. Да и, если честно, эксперты могли определить, где есть искусственное вмешательство. Теперь одиночка может подделать речь любого политика или сделать порно-ролик с любой актрисой. Для этого создаются специальные приложения вроде FakeApp, которые, разумеется, сносятся с крупных платформ, но выпадают в первых строчках поискового запроса. По отзывам пользователей, человек, впервые скачавший это приложение, может через 5 часов сгенерировать свой первый дипфейк.

Созданные с помощью таких приложений ролики получаются настолько реалистичными, что доказать их искусственное происхождение сложно. А иногда просто поздно – ролик молниеносно распространяется по соцсетям, а опровержение не успевает за скоростью распространения контента.

Подобные проекты есть не только в сфере фото или видео, но и с применением технологии VR (virtual reality, виртуальной реальности). Например, потрясающая по своей силе история воссоединения в виртуальном пространстве матери и ее умершей от рака дочери (для эмоциональных и чувствительных людей видео может показаться тяжелым):

У истоков

В 2017 году исследователи из Университета Вашингтона натренировали нейросеть на генерацию видео с бывшим президентом США Бараком Обамой. Проект «Синтезируя Обаму» («Synthesizing Obama») продемонстрировал, как «заставить» видео произносить голосом Барака Обамы любую речь, при этом губы артикулируют нужные слова. Университет Стэнфорда не остался в стороне и представил программу Face2Face, которая в режиме реального времени считывала выражение лица одного человека и переносила его на другого.

Не отставали коллеги в Университете Алабама в Бирмингеме (США): они научились синтезировать любую речь по образцу голоса длительностью 3-5 минут.

К новому 2018 году технологии были готовы к запуску нового феномена. Как видно на графике в Google Trends, интерес к дипфейкам, появившись в самом конце 2017 года, постепенно, но неумолимо растет. С середины 2019 года популярность запроса высока как никогда и не собирается снижаться. Иногда дипфейки даже догоняют появившиеся несколькими годами раньше fake news (фальшивые новости).

Вопросы власти и гегемонии

Итальянский социалист Антонио Грамши, чьи работы легли в основание многих социальных теорий современности, пишет (опираясь на работы Ленина) о борьбе за гегемонию. Долгое время право делать политические заявления и выступать в политических дискуссиях было только у избранных людей, у политиков, монархов, общественных деятелей. Кинорежиссеры вершили судьбы героев фильма, спрашивая о поворотах сюжета только свое вдохновение. Аудитория не имела права голоса. Но теперь вершителем судеб может стать каждый: политик скажет то, о чем давно мечтал избиратель, а актриса из фильма с рейтингом 4+ появится в эротической сцене.

Политическая борьба

Неудивительно в этом контексте, что дипфейки в первую очередь инструмент политической борьбы. В 2020 году много шума наделал дипфейк Extinction Rebellion, Бельгия, в котором заставили своего премьер-министра страны Софи Вильмес рассказать, что причина коронавируса – экологические проблемы:

Иногда не нужно подменять человека или слова, спикер Палаты представителей США Нэнси Пелоси говорит одну речь в одном и том же месте, но в обработанном виде она выглядит… пьяной:

Видео моментально распространилось по Facebook, который, кстати, отказался его удалять, аргументируя, что у них нет такого правила – удалять видео с непроверенной информацией. Впрочем, они уменьшили его распространение. YouTube видео удалил.

Дипфейк – мощное оружие для сетевой травли. Индийская журналистка Рана Айюб столкнулась с порно со своим участием, сгенерированным недовольными ее политической позицией.

От хейтеров пострадала медиакритик Анита Саркисян за свою феминистскую критику поп-культуры и видеоигр. Ее лицо было помещено в хардкор-порновидео, которое было просмотрено более 30 тысяч раз на сайте Pornhub.

Возможности распространения информации, та самая spreadability, о которой писал в 2013 году американский исследователь Генри Дженкинс в книге Spreadable Media, играет дурную службу – пользователь в среднем склонен жать на кнопку «поделиться», не задумываясь и опираясь скорее на привлекательность, виральность контента, нежели на его достоверность.

Социальные кампании с применением дипфейков

Как и большая часть технологий, дипфейк имеет и хорошую, светлую сторону. Я расскажу о нескольких проектах, где она применяется во имя добра.

Одна из самых опасных стран для журналистов, отнюдь не Сирия и не Ирак, – это Мексика, где регулярно происходят убийства журналистов, пишущих на политические и общественные темы. Чтобы привлечь внимание к этой беде, медиаагентство Publicis реактивировало аккаунты убитых журналистов в твиттер-аккаунты (при поддержке Twitter Мексика) и начало кампанию в этой соцсети с хэштегом #stillspeakingup (все еще говорю).

Не остановившись на этом, в рамках кампании с помощью искусственного интеллекта были сделаны видео, в которых погибшие журналисты рассказывают о своей деятельности и смерти.

Наверное, называть их «дипфейк» будет не совсем правильно, так как искусственная природа видео не только не скрывалась, но и, наоборот, подчеркивалась создателями как символ свободы слова, воскресшей из мертвых, рукописей, которые не горят.

В фильме «Добро пожаловать в Чечню» (‘Welcome to Chechnya’) рассказывается, как группа активистов помогает представителям ЛГБТ-сообщества Чечни бежать из республики и из страны.

Уже в начале съемок встал вопрос о том, как сохранить анонимность героев фильма из опасения за их жизнь и за их оставшихся в Чечне родственников. Для этого было решено использовать технологию, которая заменяла лица героев на лица европейских ЛГБТ-активистов, согласившихся предоставить свою внешность и голоса тем, кто нуждается в анонимности. В фильме «одолженные» лица можно распознать по небольшому блеру.

Еще один пример использования технологии дипфейка – проект Unfinished Votes («Незавершенное голосование»), запущенный перед выборами в США. С помощью сгенерированного искусственным интеллектом видео был «воскрешен» Хоакин Оливер, подросток, убитый в 2018 году во Флориде во время стрельбы в школе. Хоакин призывает молодых избирателей зарегистрироваться, прийти на выборы и проголосовать за политиков, которые выступают против свободного ношения оружия – сделать то, чего не успел сделать он сам. Видео сделано при участии родителей Хоакина и с их согласия.

Для фанатов

Сообщества фанатов с помощью дипфейк-технологий переделывают любимые фильмы, заменяют неугодных актеров на любимых.

Есть целая мем-культура, создающая видео с Николасом Кейджем в фильмах, в которых он никогда не снимался:

Технология заметно удешевляет некоторые моменты кинопроизводства, например, если необходимо появление на экранах актеров уже умерших или сильно изменившихся, как, например, часто бывает необходимо в саге «Звездные войны»:

Левое видео создано профессионалами в студии, правое – дипфейк. Вы видите разницу?

Порно

Дипфейки воспринимают как политическую технологию, но если оценивать количественно, 96% такого рода видео – порнографическое. 99% порнографических дипфейков делаются с участием «звезд»: популярных актрис и певиц. В большей части случаев порно-дипфейки используют именно образы женщин.

Порнодипфейки появились почти сразу за изобретением самой технологии, официально – в феврале 2018 года.

Количество погрнографических видео, сделанных с помощью искусственного интеллекта, удваивается каждые 6 месяцев. Такими темпами следующим летом их будет 180 тысяч, в 2022 году – 720 тысяч.

Самая популярная персона в «звездном» дип-порно – Скарлетт Йоханссон. Актриса, которая поневоле стала персоной, выступающей против порно-дипфейков справедливо замечает, что репутационные последствия в гораздо меньшей степени затрагивают селебрити (мы все-таки понимаем, что Скарлетт хватает ее гонораров, чтобы не сниматься в странноватых порнороликах), нежели «незвездных» мужчин и женщин.

В отличие от Скарлетт, школьной учительнице, которой даже в купальнике нельзя фотографироваться, гораздо сложнее объяснить, что на видео не она, а плод воспаленного воображения (отвергнутого) мужчины.

Борьба с дипфейками

Первого сентября 2020 года компания Microsoft анонсировала свою новую разработку – Microsoft Video Authenticator. ПО может анализировать фото или видео, чтобы обеспечить процентный шанс или даже уверенность в том, что этот отрывок видео или фото искусственно изменен. В случае с видео ПО может предоставить процент вероятности манипулирования в реальном времени на каждом кадре видео.

DARPA, агентство при Министерстве обороны США, занимается разработкой программы Media Forensics (MediFor). Она использует искусственный интеллект для определения манипуляций с видео.

Adobe подошел к решению проблемы надежности контента с другой стороны, запустив Content Authenticity Initiative. Идея похожа на подход к генерации криптовалют – у каждой единицы визуального контента должна сохраняться полная история его создания и видоизменения, чтобы любой зритель мог понять – какие изменения были внесены и кем.

Дипфейк уходит в коммерцию

Ритейл с удовольствием использует новые технологии, дополненная реальность уже стала визитной карточкой отрасли.

Коронавирус и локдаун привели к буму интернет-шопинга в мировом масштабе. И разумеется, к последующему разочарованию в накупленном, которое было меньше/больше или вообще не очень. Было бы удобно до покупки увидеть, как именно одежда будет смотреться на ее покупателе.

Именно здесь может помочь искусственный интеллект и технология, сходная с дипфейками. Например, Deepfake 2.0 Алексея Чаплыгина позволит примерить на себя одежду из интернет-магазинов:

Юридические вопросы

За «слив» личных фотографий Йоханссон хакер получил 10 лет тюрьмы. Какая ответственность за создание дипфейка против воли участника и, главное, как доказать, что видео не настоящее?

Как регламентировать посмертное использование образов людей? Хотели ли убитый подросток или мексиканский журналист, чтобы их образы посмертно использовали таким образом? Живая Скарлетт Йоханссон может хотя бы выразить свое несогласие.

Пока эта сфера законодательства очень размыта. Google добавил «involuntary synthetic pornographic imagery» («недобровольные синтетические порнографические изображения») в свой стоп-лист. Теперь, если пользователь обнаружил такие со своим участием, он может заполнить форму, и поисковик удалит эти материалы из результатов поиска. Законодательства разных стран защищают граждан разве что косвенно, через связанные нарушения. Например, если фотографии/видео для создания дипфейка были получены незаконным путем, то можно попробовать подать в суд на этом основании.

Даже когда мы говорим об использовании технологии во имя добра, все равно остаются вопросы. В фильме «Добро пожаловать в Чечню» («Welcome to Chechnya») замена лиц произошла по взаимному согласию. Использование чужих лиц вместо собственных позволяет сохранить для зрителя эмоции, выражения лиц, мимику, но при этом сохранить анонимность. Идея разделения идентичности дает нам надежду на то, что в будущем никому не придется скрываться за чужим лицом из опасения быть физически растоптанным, убитым, сгораемым страхом за свою семью.

Однако в случае с журналистами и подростком возникает вопрос – а насколько это этично? Человек может оставить завещание, где он может распорядиться своими авторскими правами на произведения, недвижимостью, машинами и т.д. Но распорядиться своим образом он не может. Кампания по привлечению внимания к безопасности мексиканских журналистов имела большой успех, попав в ТОП-5 лучших рекламных кампаний Латинской Америки, однако к использованию образа убитого подростка в политических целях многие зрители отнеслись негативно – комментарии на YouTube в основном негативные.

Что ждать в 2021 году?

Дипфейки станут еще дешевле, качественнее и проще в исполнении. Мы перестанем доверять видео как надежной информации о мире.

Как и в случае с вирусами, где разработчики антивирусного ПО всегда на шаг позади создателей вирусов, новые дипфейки будут успешно проходить проверку программным обеспечением.

Хочется верить, что в 2021 году мы увидим первые примеры надежного анти-дипфейкового законодательства.

Может быть, со временем к набору плагинов, который вы используете для поиска скидок и блокировки рекламы, добавится еще один – для предупреждения о дипфейках.

Крылатая фраза Козьмы Пруткова «не верить глазам своим» – очень актуальный девиз в наступающем 2021 году. Англоязычное Seeing is believing («Видеть – значит верить») заметно пострадало.

Прежде чем отправить сенсационное видео друзьям – проверьте надежность источника.