Мир кибербанка вызывает тревожность. Разговоры про искусственный интеллект, который захватит планету, крутятся вокруг дискуссии об этике и морали. И такой взгляд вселяет надежду.

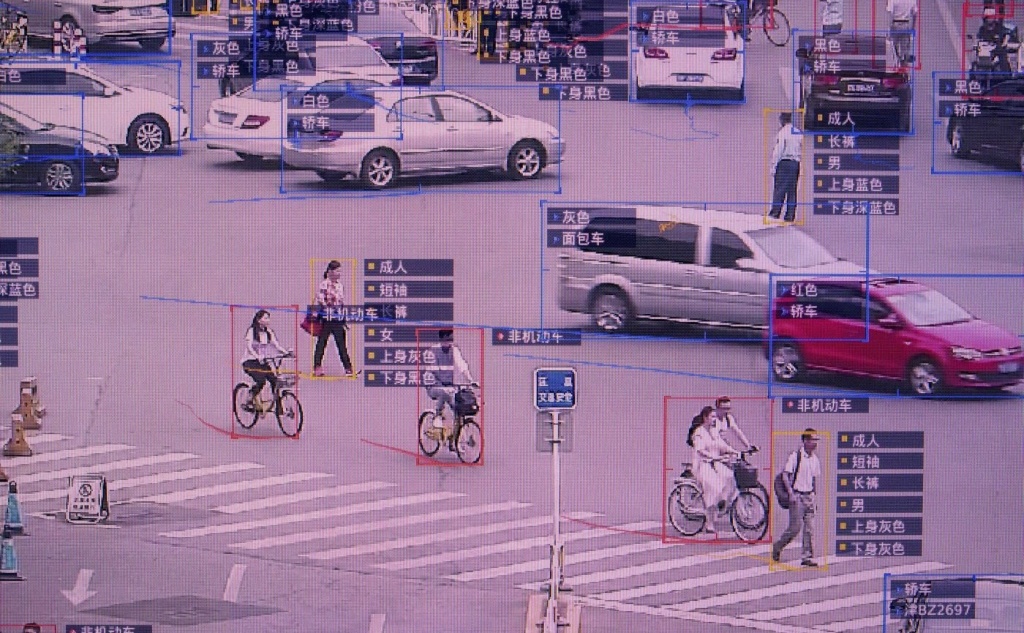

Технологии сегодня нельзя рассматривать без обсуждения этики и их влияния на общество. За 2018 год было несколько случаев, после которых пришлось переосмыслить моральную сторону. Например, у компании Cambridge Analytica оказались сведения о миллионах пользователей Facebook, и их использовали политтехнологи для влияния на результаты выборов в США; произошло смертельное ДТП с участием беспилотника, а голосовые помощники превратились в расистов и сексистов; в Китае появился социальный рейтинг, установив тотальный контроль за гражданами.

Социальная антиутопия «Черного зеркала» в деле. Она внушает страх ничуть не хуже, чем в сериале. В России уже были случаи, когда с помощью систем наблюдения преследовали политических активистов. Влияние таких алгоритмов может быть неконтролируемым.

Еще по теме: Что в черном ящике? Проблемы машинного обучения

Меня возмутило заявление профессора Китайского университета в Гонконге, основателя одного из самых дорогих стартапов в сфере ИИ по технологии распознавания лиц Тан Сяоу. Он говорит: «Мы на самом деле не забегаем настолько далеко вперед, чтобы узнать, будет ли ИИ конфликтовать с людьми. Мы просто пытаемся заработать деньги».

Не зря Джеймс Баран и Илон Маск опасались того, что может принести ИИ, и говорили, что это самый большой риск, с которым сталкивалась цивилизация. Но такое безответственное отношение к созданию технологий требует осуждения и выработки правил, которые будут отвечать принципам осознанных технологий.

Еще по теме: «Будет хуже»: трудности и вызовы гражданского сектора

Есть проблема в том, что машинные алгоритмы обучают на недостаточном объеме данных. Такие ошибки отражены в отчете State of AI, проведенном в Америке. Например, функция YouTube-перевода голоса в текст не распознает женские голоса, или при запросе «CEO» на первой странице результатов по картинкам поисковик выдает «белых» мужчин, а распознаватель фото Google маркирует темнокожих как «горилла». Отсюда и необъективная искаженная информация, которая может привести к неравноправию разных социальных групп.

А еще много зависит не только от данных, но и от самого уровня осознанности создателя или группы разработчиков. Это значит, что если им наплевать на концепцию прав человека, то и в основе разработки она не будет заложена. Только представьте, если халатное отношение со стороны разработчиков будет распространено на алгоритмы и масштабировано. Привет новой волне дискриминации, ксенофобии и религиозному экстремизму.

Несмотря на то что, комитеты по этике есть уже в Microsoft, Google, Facebook и SAP, социально ориентированные некоммерческие организации могут помочь в оценке потенциальных рисков.

Нужно это, чтобы придать алгоритмам ту самую «человечность»: не пропустить ксенофобию, нарушение справедливости, все, что бьет на доверие в обществе. Именно третий сектор ставит права и свободы человека на первое место. И сейчас задача в том, чтобы передать эти знания, требовать нормативную базу и участвовать в обсуждении.

А мы в редакции Теплицы в марте расскажем про то, какой успешный опыт уже есть и почему вопросы этики в технологиях так важны.